Hadoop Terminology

- 김영찬

- 2022년 3월 23일

- 3분 분량

Hadoop Ecosystem(Cloudera CDP)을 관리하는데 필요한 요소와 용어를 정리하면 다음과 같습니다.

YARN(얀) : 분산 클러스터의 처리를 효율적으로 관장하기 위한 리소스 관리자(Hadoop 기본 구성)

Mesos(메소스) : YARN과 동일한 역할을 하는 리소스 관리자

Oozie(우지) :워크플로우 스케줄러 시스템

Apache Airflow : Oozie를 대체할 수 있는 배치 스케줄러(Cloudera Manager에는 포함 안됨)

Zookeeper(주키퍼) : Hadoop distributed application Orchestration Solution, Active namenode 장애시 Standby로 자동 절체 HA

Tez(테즈) : MapReduce를 대체하는 query 처리 프레임워크. SQL 처리시 임시 결과를 hdfs 대신 메모리로 성능 대폭 향상

NiFi(나이파이) : Stream 기반 데이터 연계 솔루션 ß Flume

Atlas(아틀라스) : 메타데이터 metadata 및 데이터 거버넌스 시스템 ß Navigator

Sqoop(스쿱) : 하둡과 DBMS간 대용량 데이터 전송 도구

Ranger(레인저) : 하둡 보안 키 관리 서버(권한설정, 접근통제, Audit 등 보안 제공), Solr(AuditDB), MySQL(MetaDB) ß Sentry

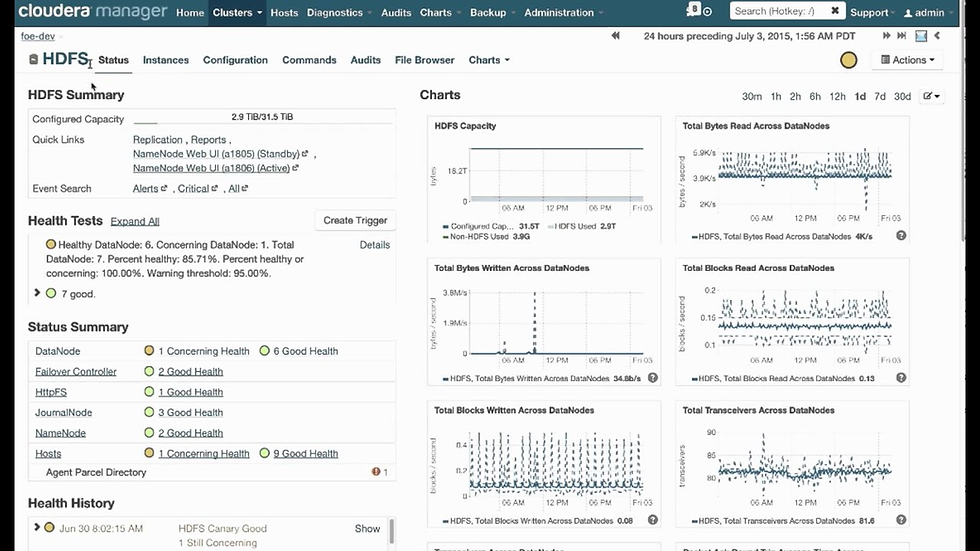

HDFS : Hadoop Distributed File System. 데이터블록과 이 데이터블록을 분산된 서버로 저장하는 메타데이터

MapReduce : HDFS상의 분산 데이터 처리를 위한 분산 컴퓨팅 프레임워크. map(처리)와 reduce(집계)로 구성

Namenode : 2대로 HA 구성, Active-Standby 동작(forcefialover), 분산된 데이터블록을 하나의 논리적 디스크 볼륨으로 보여줌

Datanode : HDFS에서 Namenode의 도움을 받아서 데이터 블록을 읽고 쓰는 서버

HBASE : HDFS 기반위에서 동작하는 구글 Big Table 기반의 분산 컬럼기반 NoSQL

Stream Processing : Streaming 분석이나 Realtime 분석에 쓰이는 솔루션(배치와 반대)

Lambda Architecture : 람다 기호 처럼 streaming 데이터와 배치 데이터 두개의 흐름을 join해서 실시간 처리하는 구조

Hive : Hadoop 1.0 빅데이터에 대한 MapReduce 엔진 기반의 SQL 분석 솔루션

Hive on Tez : Hadoop 2.0에서 MapReduce를 대체하여 SQL 중간 처리 결과를 hdfs가 아닌 메모리에 보관하여 처리하는 솔루션

SerDe : Serializer/Deserializer, Hive 파일 포맷(ORC, Parquet 등)으로 원시 데이터를 읽고 쓰기 위한 구현 기능(파일 포맷별 SerDe 존재)

Spark : 순수 메모리 기반의 Hadoop 빅데이터 분석 솔루션. 데이터 연계, 처리, 데이터프레임 생성, SQL 분석, 실시간 스트리밍 분석, 머신러닝 지원

ESP(Event Stream Processing) : kafka Stream, Flink, Nifi, Spark, Storm

CEP(Complex Event Processing) : Esper, Drools

이벤트 처리 보장 : At-least-once, At-most-once, Exactly-once(최적, 성능문제)

OpenShift : RedHat’s Kubernetes cluster solution

Ozone : Scalable, redundant, and distributed object store for Hadoop

HMS : Monitoring, administration and lifecycle management for Apache Hadoop clusters

LLAP : Live Long and Process, HIVE에서 HDFS datanode와의 직접적인 상호작용을 대체 컬럼 데이터의 프리패칭 및 캐싱을 지원

DAG : Directed Acyclic Graph, 순환하는 사이클이 존재하지 않는 비순환 일방향 그래프

Hue : Open Source SQL Editor for Databases and Datawarehouses. Support for Hive, Impala, SparkSQL, Phoenix, Elastic Search

Knox(녹스) : REST API Gateway for Hadoop

Zeppelin : 웹 기반 편집기로 SQL, Scala 등과 함께 데이터 기반 대화식 데이터 분석 및 문서 협업 등을 지원함

Parquet(파케이) : 중첩된 데이터를 효율적으로 저장할 수 있는 컬럼 기반 데이터 저장 포맷 – Spark 위주

ORC : Optimized Row Column 컬럼기반 HDFS 파일 시스템 저장 포맷 – HIVE 위주

Avro : HDFS 파일 시스템 저장 포맷, serialization 통신을 위한 규격

RCFILE : Record Columnar File, 컬럼기반으로 데이터를 압축하여 저장하는 파일 형식

Kudu(쿠두) : 메모리 스토리지(SSD)와 메모리 기반 column 방식 데이터 스토어 매니저. Impala와 연동하여 SQL 기반 분석에 이용

HashiCorp Vault : 프로그램에서 사용하는 기밀정보(암호, 암호화 키, 토큰 등)을 안전하게 보호하고, 암호화 해주는 툴

Kafka : Linkedin에서 개발한 Streaming Processing을 지원하는 분산 메시지 브로커 시스템

Nutch : Hadoop의 원조로 십억 페이지의 웹 문서 검색을 위해 개발된 Lucene 검색엔진의 하위 프로젝트

Hadoop : Nutch 개발에 Google의 GFS 분산파일시스템과 MapReduce 개념을 결합하여 탄생한 빅데이터 저장 및 분석 시스템

DataBricks : Spark를 개발한 UC Berkeley 출신들이 만든 회사로 Spark 빅데이터 분석을 위한 클라우드 제공(무료 버전도 있음)

Amazon EMR(Elastic MapReduce) : AWS 클라우드 기반 하둡 빅데이터 처리 플랫폼(Hive, Spark, HBase, Flink, Hudi Presto 등 지원)

Flink : Streaming 및 배치 처리 플랫폼(Spark Streaming 대응)

Hudi(Hadoop Upserts, Deletes, Incrementals) : stream 처리를 지원하면서 Hive 테이블에 CUD(create, update, delete)를 제공

Presto : 페이스북에서 개발한 메모리 기반 SQL 처리 엔진(PrestoDB, PrestoSQL)

HCatalog : 하둡 기반 메타데이터 관리 서비스로 Hive 등에서 테이블 및 메타데이터 정보를 손쉽게 관리하고 이용

댓글